Física para imitar al cerebro: el Nobel premia los fundamentos del Machine learning

Los científicos galardonados con el Premio Nobel de Física 2024 utilizaron herramientas de la física para construir métodos que ayudaron a sentar las bases del poderoso aprendizaje automático actual. John Hopfield creó una estructura que puede almacenar y reconstruir información. Geoffrey Hinton inventó un método que puede descubrir de manera independiente propiedades en los datos, lo que ha sido clave para las grandes redes neuronales artificiales que se utilizan en la actualidad.

Muchas personas han experimentado cómo las computadoras pueden traducir entre idiomas, interpretar imágenes e incluso llevar a cabo conversaciones razonables. Lo que quizás sea menos conocido es que este tipo de tecnología ha sido importante durante mucho tiempo en la investigación, incluyendo la clasificación y análisis de grandes cantidades de datos. El desarrollo del aprendizaje automático ha explotado en los últimos quince o veinte años y utiliza una estructura llamada red neuronal artificial. Hoy en día, cuando hablamos de inteligencia artificial, a menudo nos referimos a este tipo de tecnología.

Aunque las computadoras no pueden pensar, las máquinas ahora pueden imitar funciones como la memoria y el aprendizaje. Los galardonados de este año en física han contribuido a hacer esto posible. Utilizando conceptos fundamentales y métodos de la física, han desarrollado tecnologías que utilizan estructuras en redes para procesar información.

El aprendizaje automático difiere del software tradicional, que funciona como una especie de receta. El software recibe datos, que son procesados de acuerdo con una descripción clara y produce resultados, de manera similar a cuando alguien recolecta ingredientes y los procesa siguiendo una receta, produciendo un pastel. En lugar de esto, en el aprendizaje automático la computadora aprende por ejemplo, lo que le permite abordar problemas que son demasiado vagos y complicados para ser gestionados mediante instrucciones paso a paso. Un ejemplo es interpretar una imagen para identificar los objetos que contiene.

Imita al cerebro

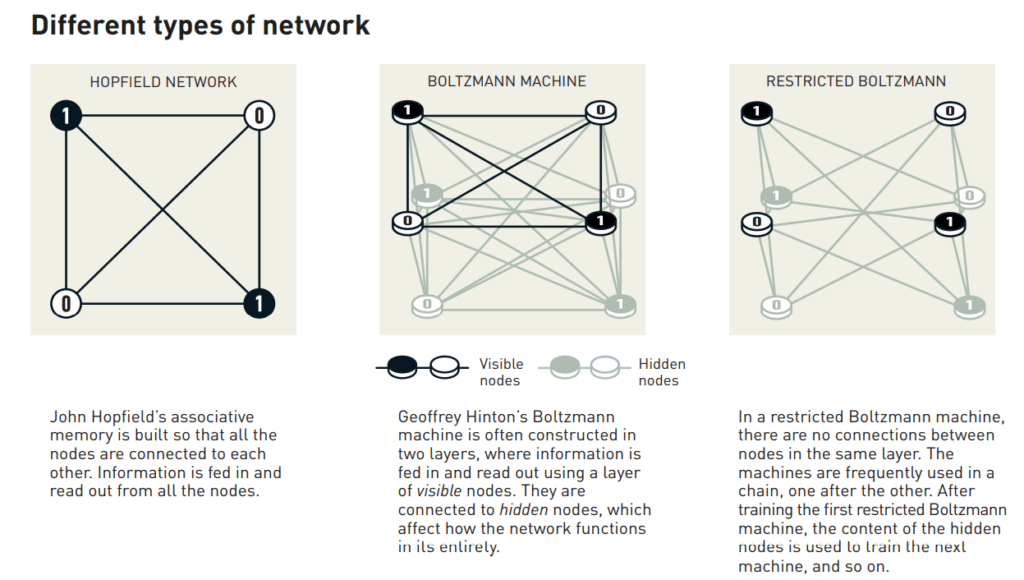

Una red neuronal artificial procesa información utilizando toda la estructura de la red. La inspiración inicial provino del deseo de entender cómo funciona el cerebro. En la década de 1940, los investigadores comenzaron a razonar sobre las matemáticas que subyacen a la red de neuronas y sinapsis del cerebro. Otro componente clave vino de la psicología, gracias a la hipótesis del neurocientífico Donald Hebb sobre cómo ocurre el aprendizaje: las conexiones entre neuronas se refuerzan cuando trabajan juntas. Más tarde, estas ideas fueron seguidas por intentos de recrear el funcionamiento de la red cerebral mediante la construcción de redes neuronales artificiales como simulaciones en computadora. En estas, las neuronas del cerebro son imitadas por nodos que se les asignan diferentes valores, y las sinapsis están representadas por conexiones entre los nodos que pueden volverse más fuertes o más débiles. La hipótesis de Donald Hebb todavía se utiliza como una de las reglas básicas para actualizar las redes artificiales a través de un proceso llamado entrenamiento.

A finales de la década de 1960, algunos resultados teóricos desalentadores llevaron a muchos investigadores a sospechar que estas redes neuronales nunca serían de utilidad real. Sin embargo, el interés en las redes neuronales artificiales resurgió en la década de 1980, cuando varias ideas importantes empezaron a tener impacto, incluyendo el trabajo de los galardonados de este año.

Memoria asociativa

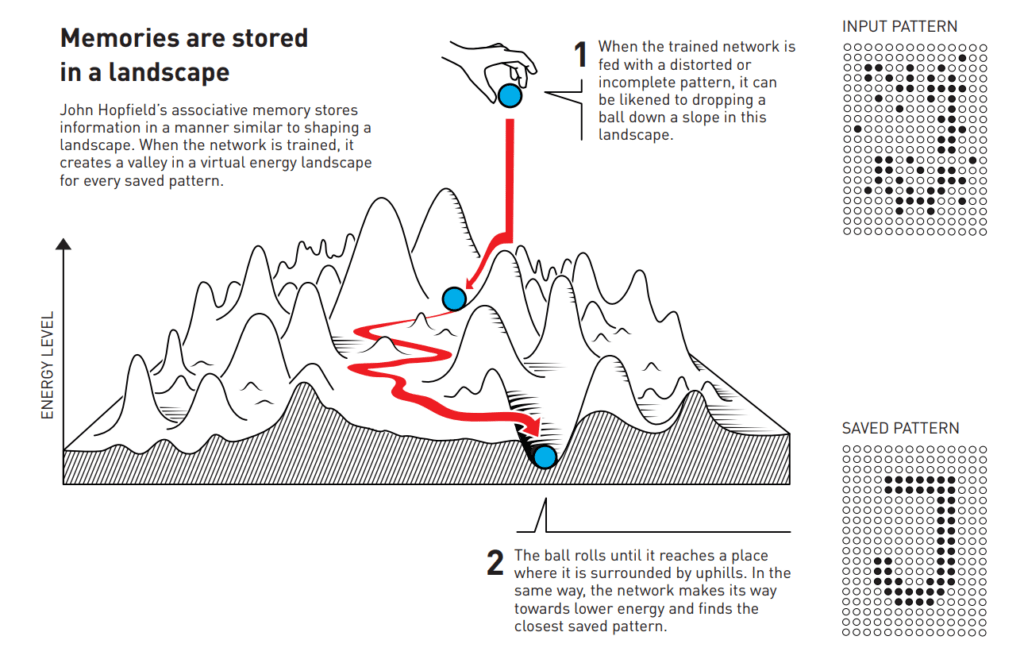

Imagina que estás tratando de recordar una palabra bastante inusual que rara vez usas, como una que describa el piso inclinado que a menudo se encuentra en cines y salas de conferencias. Buscas en tu memoria. Es algo como rampa… ¿quizás radial? No, no es eso. ¡Rastrillo, eso es!

Este proceso de búsqueda a través de palabras similares para encontrar la correcta es similar a la memoria asociativa que el físico John Hopfield descubrió en 1982. La red Hopfield puede almacenar patrones y tiene un método para recrearlos. Cuando a la red se le da un patrón incompleto o ligeramente distorsionado, el método puede encontrar el patrón almacenado que es más similar.

Hopfield ya había utilizado su formación en física para explorar problemas teóricos en biología molecular. Cuando fue invitado a una reunión sobre neurociencia, se encontró con investigaciones sobre la estructura del cerebro. Quedó fascinado por lo que aprendió y comenzó a pensar en la dinámica de redes neuronales simples. Cuando las neuronas actúan juntas, pueden dar lugar a características nuevas y poderosas que no son evidentes para alguien que solo mira los componentes separados de la red.

En 1980, Hopfield dejó su puesto en la Universidad de Princeton, donde sus intereses de investigación lo habían llevado más allá de las áreas en las que trabajaban sus colegas físicos, y se mudó a través del continente. Había aceptado una oferta de una cátedra en química y biología en el Instituto de Tecnología de California (Caltech) en Pasadena, en el sur de California. Allí, tenía acceso a recursos informáticos que podía utilizar para experimentar libremente y desarrollar sus ideas sobre redes neuronales.

Sin embargo, no abandonó su base en la física, donde encontró inspiración para su comprensión de cómo los sistemas con muchos componentes pequeños que trabajan juntos pueden dar lugar a fenómenos nuevos e interesantes. Se benefició especialmente de haber aprendido sobre materiales magnéticos que tienen características especiales gracias a su espín atómico, una propiedad que convierte a cada átomo en un pequeño imán. Los espines de los átomos vecinos se influyen entre sí; esto puede permitir que se formen dominios con espines en la misma dirección. Utilizó la física que describe cómo se desarrollan los materiales cuando los espines se influyen mutuamente para crear una red modelo con nodos y conexiones.

Neuronas naturales y neuronas artificiales

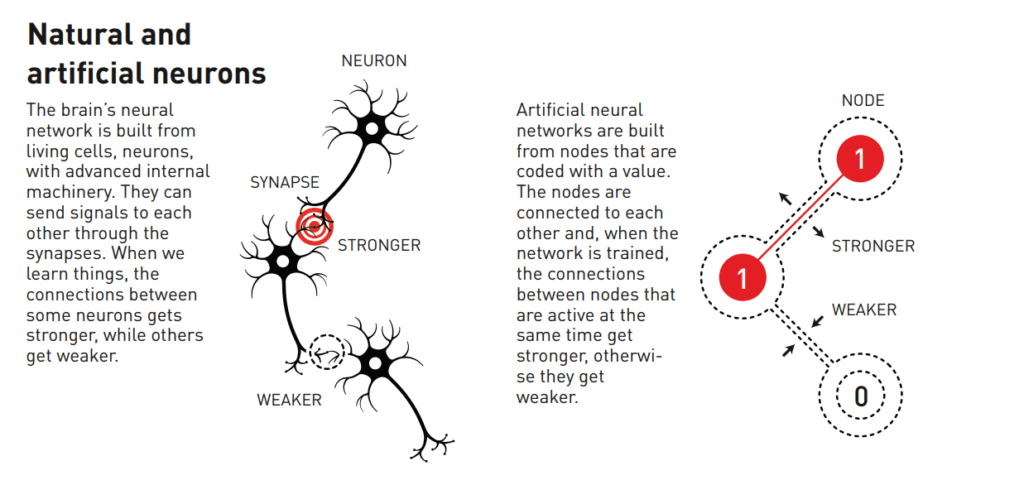

La red neuronal del cerebro está construida a partir de células vivas, las neuronas, con maquinaria interna avanzada. Estas pueden enviarse señales entre sí a través de las sinapsis. Cuando aprendemos algo, las conexiones entre algunas neuronas se fortalecen, mientras que otras se debilitan.

Las redes neuronales artificiales están formadas por nodos que se codifican con un valor. Los nodos están conectados entre sí y, cuando la red se entrena, las conexiones entre nodos que están activos al mismo tiempo se fortalecen; de lo contrario, se debilitan.